高文:城市大脑2.0已来,数字视网膜是核心驱动力

摘要 城市大脑是现有智慧城市中的一个核心系统,它将算力及数据汇聚到一起,加上算法,就能发挥巨大的作用。

【CPS中安网 cps.com.cn】 2020年年初国家提出的“新基建”,为技术变迁和行业发展,带来了新的时代机遇,而智慧城市也成为全国城市发展变革的重要一环。

城市大脑是现有智慧城市中的一个核心系统,它将算力及数据汇聚到一起,加上算法,就能发挥巨大的作用。

比如,将网络数据、政务数据、社会数据等等,汇集到一起,然后提供一个云计算服务,就可以提升政府效率、加速企业创新、促进生活便捷。

在智慧城市系统之中,汇集了各类各样的数据,其中有90%左右的数据都与图像、视频相关联,如何处理好图像和视频数据,在城市大脑系统中是非常关键的要素。

那么,现在城市大脑系统的发展到了哪个阶段?从系统1.0到2.0,哪些痛点被解决了?技术又有哪些创新呢?

在8月7日第五届全球人工智能与机器人峰会(CCF-GAIR 2020)上,中国工程院院士、鹏城实验室主任高文,分享了主题为《城市大脑2.0-边端云处理分工的人工智能赋能系统》的报告。

高文院士在报告中,从城市大脑1.0的现状、问题,谈到城市大脑2.0的创新、优势,以及智慧城市发展的关键技术和能力。

1、城市大脑1.0的现状

城市大脑是智慧城市的核心系统,是算力和数据的汇聚地,是生产力和生产资料的集中展现。

它也是超大规模的人工视觉系统应用,通过数据的汇聚、治理、计算、分析、挖掘和调度,完成数据的全流程加工,面向行业提供不同层次的产品和服务。

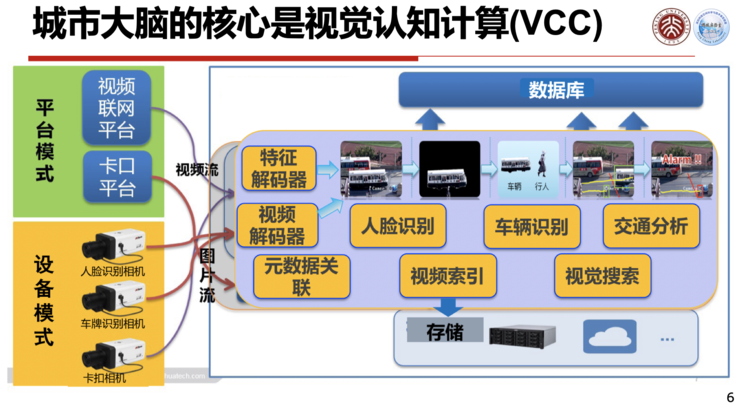

所以,视觉认知计算(VCC)是城市大脑的核心。目前,视频存储、分析与识别都在云上完成,分析识别的视频路数与云服务器的算力成正比。

在现有的系统中,数据基本以图像与视频两种形式进入:

第一种模式:摄像头就是一个简单的传感器,捕捉到图像或者视频以后,进行一个编码压缩,传送给云端,云端将它存储起来。

也可能将它解码之后进行分析,识别出人脸、车辆,或者进行交通数据的分析等等,这是一种信息或者数据感知的模式。

另一种模式叫做智能终端,在摄像头这一端就把人脸或者车牌等信息识别出来,识别出来的信息被传送到云端,直接可以进行分析使用。

这两种模式是目前城市大脑中数据使用的主要模式,当然这两种模式都多多少少存在一些问题。

如果仅仅作为一个感知终端,后面如果需要调用,除了解码以外,还要进行特征提取等工作,需要大量的计算程序,这些计算非常耗费云计算的算力资源。另外,智能终端还无法识别出未被指定的人或物。

所以,城市大脑需要一个更好的系统,这个系统不仅云上算力资源需求不多,而且可以完成一些未经规定的动作。

换句话说,以云计算为核心的城市大脑1.0目前存在的一些问题是,系统各个部分分工协调不太好,系统成本比较高,响应速度慢,数据的可利用度比较低。

如果要从1.0演进到2.0,首先要面临一些挑战:

第一,海量数据≠大数据

现在的城市大脑1.0,它是一个具有海量数据的系统,但是这个海量数据并不等于大数据,因为90%的海量数据都是没有结构化的,只是进行了一个简单的编码压缩。

第二,数据海量 vs 低价值

另外,这些数据的价值也比较低,它不是结构化的,你无法在上面进行分析,这也是为什么很多智慧城市的视频数据,一段时间之后就被覆盖了。

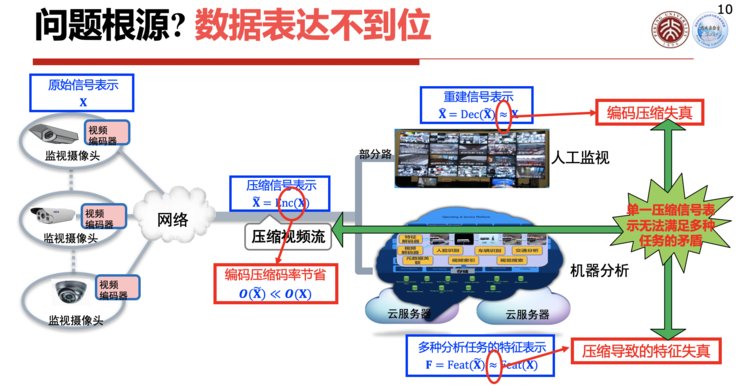

高文院士表示,问题的实质是现有城市大脑里的数据表达是不到位的。

如果只是在感知数据后,将编码压缩送到云端,它还是一个非结构化的数据;如果能把它识别出来是张三、李四,或者车牌号多少,虽然它已经结构化了,但是它是过度结构化的,对于没有规定的任务就无法执行了。

所以需要一种泛化能力更强的数据表达,这个数据的表达是一个机缘表达,用这些机缘既可以完成现有的任务,也可以完成现在还没有定义的一些任务。

这些数据表达想要得到一个比较好的结果,整个系统就必须做得好,包括系统的智力、性能(响应时间、并发、吞吐)、效率(耗电多大)等等。

如果某套系统可以通过评测,那就代表这套系统比较智能化了。

城市大脑1.0系统的弊端在于:它的智能代价比较高,要么是造价高、要么就是耗电高。

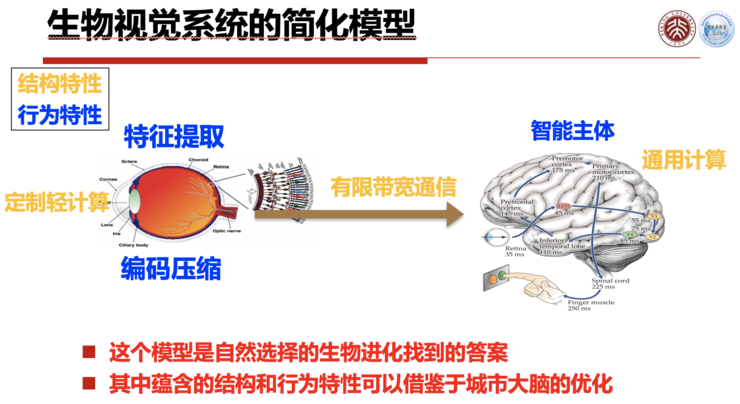

如果要将城市大脑1.0升级到2.0,高文院士表示,可以借鉴人的视觉系统,比如人的视网膜、视觉通道、大脑分工是非常协调和高效的。

从视网膜传到大脑之间,是一个特征压缩,被称为:特征编码,但这个编码和现在传统的图像编码并不一样,它是一个特征压缩编码的东西送到大脑中去。

城市大脑2.0就是借鉴这样一个系统提出的一个体系架构,不仅能传特征,还能传压缩图像。这个体系架构需要数字视网膜的技术及其标准化,现在这些思路、技术、标准化都逐步到位。

2、城市大脑2.0:数字视网膜

高文院士认为,城市大脑2.0是一个边、端、云合理分工的系统,而把边、端、云结合的最核心的技术叫做数字视网膜,它是整个城市大脑2.0里面一个基本架构,又被称为仿生视网膜的计算架构。

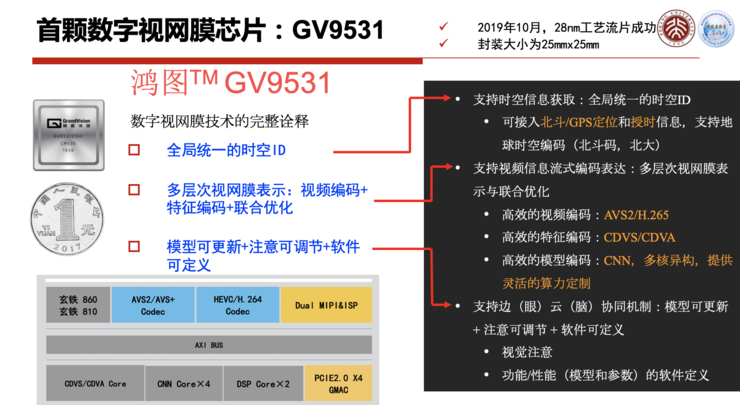

数字视网膜目前有8个特征可以定义它:

1、 使用全网统一的时间;

2、 可定位,可标识,提供精确地理位置,如GPS、Baidou北斗;

3、 视频编码:为了存储和离线观看的影像重构;

4、 特征编码:为了模式识别和场景理解的紧凑特征表示;

5、 联合优化:模拟生物视网膜,支持视频流与特征流联合编码优化,城市大脑有两个码流,视频编码压缩流和特征编码压缩流,这两个码流会捆绑到一起进行传输,所以要有一个优化策略,把这个带宽到底分多少给视频编码、分多少给特征编码,通过一个联合优化,使得整个系统达到最优。

6、 模型可更新:支持端/边深度学习模型的自适应迁移、压缩、更新与转换;

7、 注意可调节:模拟视觉注意机制,在端设备、感知网络等层面实现动态注意调节;现在的摄像头没有“注意”,只能人工拉近拉远调节它,做不到自动的注意可调节。

8、 软件可定义:支持端边云协同计算与推理,实现特征实时汇聚与视频按需调取。系统要想升级,可以通过软件定义的方法,对系统自动升级。

要想把数字视网膜技术全部用起来,这里面有一些使能技术。

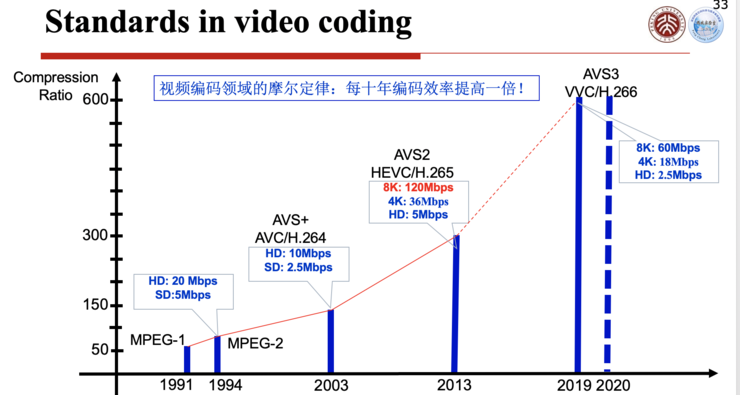

第一个使能技术,是视频编码。

现在做城市大脑、监控系统都离不开视频编码,摄像头里面都有一个视频编码芯片,视频编码芯片用的标准,最早期是H.264,或者用AVS的编码标准。

最近开始使用H.265或者AVS2的标准,未来不久就会用上H.266和AVS3的标准,这个标准差不多每10年就会更新一代,效率每10年就会提高一倍。

为什么能够做到编码压缩?一个视频就是一个图像序列,图像序列里面包含了很多数据的冗余,基本上有三大类冗余:一类是和空间冗余有关的,一类是和时间冗余有关的,另外一类是和编码冗余有关的。

现在整个视频编码里面用的算法,叫做混合视频编码架构,这个混合就把刚才三种主流的冗余用不同的算法去掉。

比如说为了去除空间冗余,一般我们采用正交变换,比如说DCP变换等把它去除掉。

为了去除时间上的冗余,就是帧和帧上的冗余,一般我们会采取预测编码,比如说各种各样的滤波器,把帧间的冗余去除掉。

为了使得编码的分配最符合熵的定义,可以使用信息熵编码来去除编码上的冗余。

这三个冗余都去除干净了,整个视频流里就可以压得很小,只有有用的信息、有用的数据甩出去,这些冗余都被挤压掉了,这是视频编码。

要想把视频编码做得好,算法要做得很精,随着时间的推移,可以用计算、带宽把这些东西一点点都去除掉。

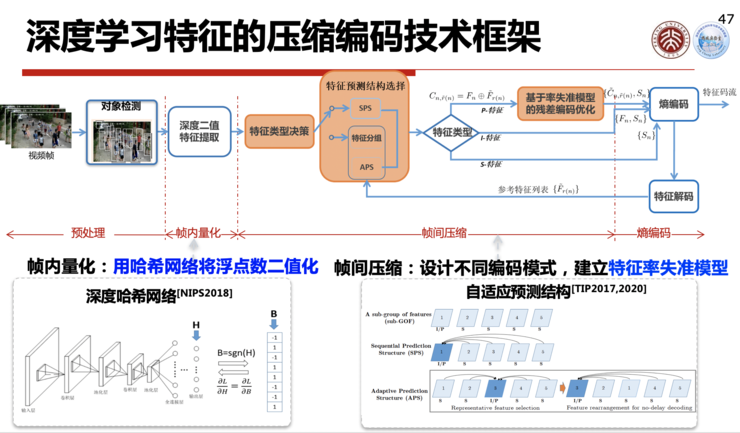

第二个使能技术,是特征编码。

这是非常关键的一个使能技术,这个技术的标准有两部分核心的内容,一部分叫CDVS,一部分叫CDVA,它们也是国际标准MPEG-7里面的两部分。

为什么要做视觉特征的压缩呢?因为根据不同的特征,提取出来的特征数据可能很大,如果不压缩的话,特征数据可能比图像本身都大,所以要么就传个图像过去,要传特征的话数据太大,所以就要对它进行特征压缩。

怎么进行压缩?如果是先把图像编码传过去,再提取特征,再进行识别,和先把特征提取出来,然后把特征传过去再识别,这两个其实有一个剪刀差,可能有时候识别率会相差百分之二三十。

先压缩了以后,可能有一些比较有用的特征丢了,因为所谓编码压缩,它是保留公共部分,把一些非公共的、非常见的东西压缩掉了,而非常见的部分恰恰可能是特征,所以把这个打磨掉以后,它的识别率可能就下来了,所以要先提特征,再在云端技术识别这样一个技术策略。

当然先提特征,怎么样提的特征体量比较小,我们初期是采用手工作业的策略,当然手工特征怎么支持深度学习,这是另外一个问题,后面我们做了第一版以后,又专门做了一个面向深度学习的编码压缩的框架,这个主要是给小视频来做的,有了这两个部分以后,基本上可以应对图像特征编码和视频特征编码这两个需求。

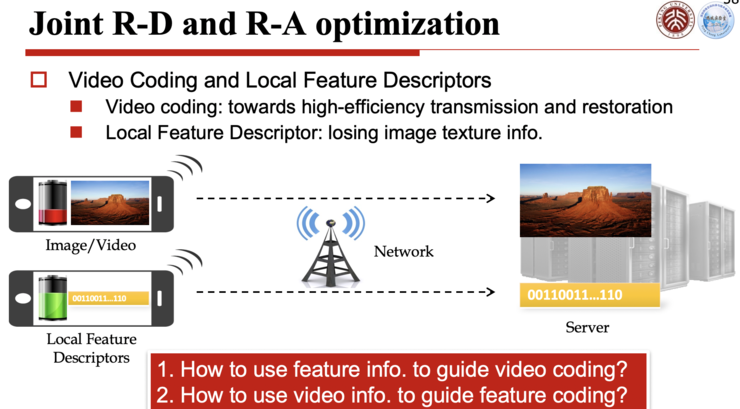

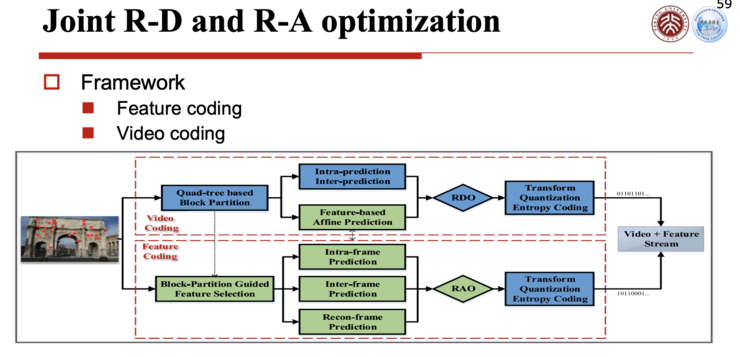

第三个使能技术,叫做联合优化。

所谓联合优化,就是在视频编码和特征编码之间,要找到一个最优的结合点,使得这两个流捆绑到一起的时候,脑力分配是最优的,上面这个流是视频压缩流,下面这个流是特征压缩流,这样送到云里,它俩合起来是最优的。

怎么能够做到最优呢?因为各自的优化模型都是有的,比如现在看到的这些是上面这部分,它是一个视频编码优化的流程,上面的虚线是视频编码,下面的虚线是特征编码,这两个编码在右端,合成一个流,就是视频和特征流。

这一个流怎么样优化呢?要设置一个联合优化流程,把它放到一起去优化。视频编码的优化模型叫RBO,RBO就是给定码率损失最小的优化模型,它的优化曲线就是右下角这个曲线。在识别特征表达方面,它有一个RAO,就是给定码率,让精确度最高的优化模型。

这个优化模型给的曲线是反过来的,所以把这两个需要优化的东西给它放到一个优化函数里面表达出来,就是这张图的表达,根据这个东西联合求解一个优化的解。

第四个使能技术,是深度学习模型编码的使能技术。

就是通过多模型的重用,通过模型压缩更新来做。这是深度学习怎么样去通过重用,去使得整个模型的重用精度更高。

这个重用既包括现有模型的重复使用,也根据目标模型训练所得到的提升,使得优化做得更好。

多模型重用,如果是在学习体系里面把它用好的话,它的性能就可以提高得比较好,所以怎么样使得这个多模型编码压缩,使得在重用当中可以快速地更新一个模型,就使得这个性能不停地提升,这两个就是模型编码的主要动机,有了这个就可以使得当模型训练完了以后,压缩完了以后就可以快速推到终端去升级模型。

上面这些使能技术,最后它要汇总到一个芯片里面,这个芯片现在在北大杭州研究院下面的一家公司做出来了,第一个数字视网膜的芯片叫GV9531,刚才的8个特性,这个芯片全都是支持的。

除了数字视网膜本身以外,现在配合人工智能技术的推进,也在推动中国的一些AI技术的国家标准,包括神经网络模型表示与压缩的标准、城市级大数据汇集关联的规范和标准,包括这些标准研究开发的路线图,什么时候要把哪个标准提出来完成等等。

数字视网膜,简单来说是三个编码流合并的系统,当然前两个是最主要的,就是视频流和特征流,这两个流时时刻刻都是汇集到一起进行传输的,第三个是模型编码,只是在模型需要压缩的时候,从云端推到边缘端或者终端上,进行一些增量的更新。

3、城市大脑2.0的优势

城市大脑1.0是一个以云计算为核心的系统,由于系统各个部分分工协调不太好,所以系统成本比较高,响应速度慢,数据的可利用度比较低。借鉴人的视觉系统,比如说人的视网膜、视觉通道、大脑分工非常协调,非常合理。

城市大脑2.0的核心在于数字视网膜及其标准化,它相较城市大脑1.0具备四大方面的性能提升:

1、它有先进视频编码技术:节省存储和带宽50%以上;

2、它可以定制ASIC边缘计算:节省云计算资源90%以上;

3、它能在原始图像上特征提取:低延时和高精度;

4、它还可以做标准化特征的提取,存储和复用:显著提升信息密度和价值。

现在鹏城实验室对城市大脑2.0——鹏城云脑,有一些较完整的设计和规划,鹏城云脑到现在为止已经投入了几十亿元去打造,鹏城云脑只有100P的算力,虽然说只有100P的算力,这也是到目前为止国内作为AI训练算力最大的一套系统。

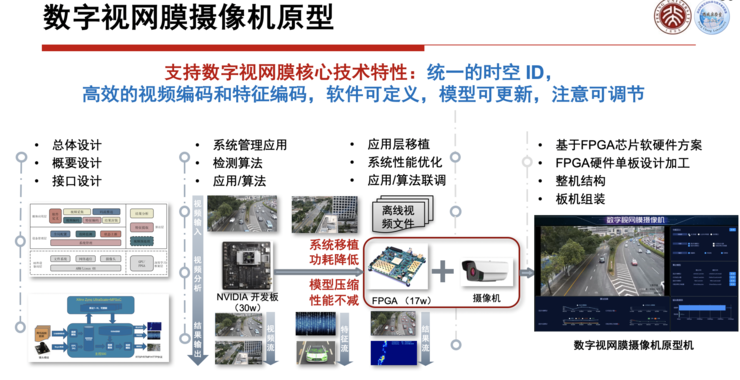

后面还会有更强的系统,现在有一个原型,可以有数据进来,对数据进行标注、采集,可以进行训练,训练完了以后就可以用刚才这些和芯片有关的系统进行提取,然后可以分析和识别。

这个原型系统,一般边缘用的,甚至在云端大数据服务里面用的东西,现在都在逐步进入系统,上面会有各种各样的参考软件,去配合硬件的东西,最上面是开源的算法训练,有这些东西之后,将来在鹏城云脑上就会对城市大脑进行比较强有力的支持。

当然这个系统要想完善,可能还需要一点时间,还需要在更多的地方去做实验验证,等这些技术都成熟了,标准全都到位了,甚至城市大脑2.0真正运营起来,对中国的城市化、智能城市等等方面会有一个比较大的贡献。

本文部分内容和图片来自雷锋网

责任编辑:lxy